Wer die Medien mit offenen Augen und Ohren verfolgt, dem wird der Supercomputer Watson von IBM sicher schon begegnet sein. Die Besucher der HR-Messe Zukunft Personal hatten 2017 sogar fast keine Möglichkeit, sich dem Thema Watson und HR zu entziehen. In einem eigenen Bereich neben der Bloggerlounge gab es Einblicke, was Watson schon heute für HR tun kann. Und einen Ausblick, wohin dies in Zukunft führt. Im Anschluss an einen IBM Watson Workshop hatte ich Gelegenheit zu einem Gespräch mit IBM Thought Leader Sven Semet. Meine –wie immer kritischen- Gedanken zum Thema Supercomputer, Big Data und People Analytics.

Robot-Recruiting, Matching und Big Data

Nach dem Grundlagenbeitrag zum Thema Robot-Recruiting und Matching-Verfahren sowie dem Praxistest des Persönlichkeits-Matching Tools von GOOD&CO ist dies mein dritter Beitrag zu diesem Themengebiet. Diesmal soll der Schwerpunkt auf Big Data liegen.

Definition von Big Data

Der Begriff unterliegt einem kontinuierlichen Wandel und wird im englischen Sprachraum derzeit vor allem wie folgt definiert:

Big Data bezeichnet Datenmengen, die zu groß, zu komplex, zu schnelllebig und zu schwach strukturiert sind, um sie mit herkömmlichen Methoden der Datenverarbeitung auszuwerten. Ergänzend werden damit Technologien beschrieben, die zum Sammeln und Auswerten dieser Datenmengen verwendet werden.

Warum sind Big Data Analysen für Recruiter überhaupt wünschenswert?

Eine durchaus berechtigte Frage. Laut IBM-Experten gehen die Anwendungsgebiete in unterschiedliche Richtungen. Bereits heute können für Recruiter vor allem Watson-Einsatzbereiche spannend sein, wie beispielsweise

- Priorisierung der zu bearbeitenden Beschaffungsaufträge

- Kandidaten-Scoring und Ranking der Kandidaten

- Real-Time-Marktanalysen zum Image des Unternehmens

Dabei definiert IBM die Watson-Technologie nicht als Supercomputer, sondern genau genommen als Plattformen künstlicher Intelligenz oder sogenannter erweiterter Intelligenz. Im Folgenden meint der landläufige Begriff Supercomputer also stets KI-Plattform.

Priorisierung von Beschaffungsaufträgen

Auf Basis historischer Informationen sowie eines sogenannten IBM Talent Frameworks, werden durch Watson Prognosen erstellt, welche Beschaffungsaufträge mit welcher Priorität anzugehen sind. Dabei werden die Jobbesetzungsaufträge auf Basis von Attributen wie zum Beispiel Kompetenzen, Einsatzort und Karrierelevel möglicher Bewerber analysiert. Daraus wird errechnet, wie zeitlich aufwändig der Beschaffungsprozess sein wird.

Kandidaten-Scoring und Matching mit IBM Watson

In diesem Einsatzbereich werden Attribute aus Bewerbungsunterlagen extrahiert, analysiert und verglichen. Anders als beim klassischen Matching wird für den jeweiligen Job aus historischen Daten ein sogenanntes success profile im Sinne eines Wunschbewerbers generiert und dagegen gematcht. Das Ergebnis kann mittels eines cognitive scores in bestehende ATS-Systeme übergeben werden.

Mehrere Probleme sehe ich persönlich dabei: Zum einen sollte bei der bekannt mangelhaften Qualität der Stellenanzeigen der meisten Unternehmen die Basis besser nicht dieses stark aggregierte und für allerlei SEO-Zwecke auf Suchalgorithmen in Stellenbörsen optimierte Dokument sein. Zum anderen stellt sich die Frage, ob die für die Erstellung des Profils verantwortlichen Hiring Manager den Wunschkandidaten in relevanten und tatsächlich matchbaren Kategorien wirklich so genau definieren können. Falls ja, meinen Respekt!

Social Listening durch Supercomputer

In diesem Anwendungsfall bedient sich Watson zur Validierung und Objektivierung des Unternehmensimages im Markt des sogenannten Social Listenings. Dabei werden Stimmungsbilder auf Plattformen wie kununu oder glassdoor oder aus Netzwerken wie Twitter aufgenommen und in die Analyse integriert. Es entstehen Einblicke für die Recruiter, um die Talentkommunikation in den Markt hinein den gefundenen Gegebenheiten anzupassen.

Wie sind die Szenarien aus Sicht eines HR-Praktikers zu bewerten?

Vorurteilsfreie und objektive Bewertung der Bewerberunterlagen?

Dort wo es in zwischenmenschlichen Kontakten immer um individuelle Emotionen, Klischees und Vorurteile, somit um Wahrnehmungsdefizite geht, bringt ein Algorithmus die notwendige Objektivität. So die Theorie. Aber hilft das wirklich gegen Diskriminierungen und schafft eine objektive Bewertungsbasis für Bewerberunterlagen?

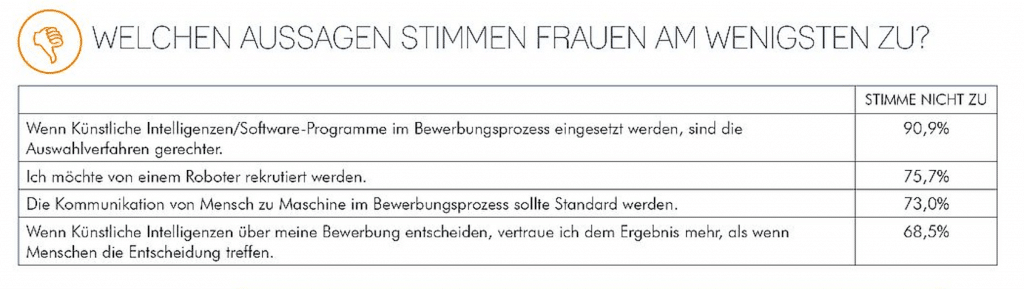

Nach einer aktuellen Befragung glauben allerdings über 90% der Frauen selbst nicht an gerechtere Auswahlverfahren durch den Einsatz von Algorithmen.

Versubjektivierte Objektivität? – Mustererkennung taugt nichts ohne Interpretation

Wenn man die Arbeitsweise von Algorithmen betrachtet, dann sind diese insbesondere große Meister im Erkennen von Mustern. Nehmen wir also mal an, wir würden einen Supercomputer ungestützt an eine Analyse setzen, um wesentliche Erfolgskriterien für den beruflichen Aufstieg in Richtung Führungskarriere zu eruieren. Dann würde dieser wahrscheinlich die Faktoren „männlich“ und „weiße Hautfarbe“ als positives Erfolgsmuster erkennen. Daraus jetzt den Wunschkandidaten zu errechnen, wäre möglicherweise zwar mathematisch korrekt. Ob es auch richtig, im Sinne von gewollt ist, lässt sich aber diskutieren.

Mein Beispiel hat Seven Semet wahrscheinlich schon öfters gehört. Er erklärt mir, dass man in diesem Fall die Algorithmen einem kundenspezifischen Training unter Einbezug der Diversity-Strategie unterziehen müsse. Das leuchtet mir ein, wenngleich ich mich frage, wie Unternehmen diese Diversity-Strategie so aufbereiten und schärfen können, damit sie einer Computeranalyse zugänglich ist. Bunte Powerpoint-Folien mit Absichtserklärungen werden vermutlich wenig hilfreich sein in diesem Zusammenhang.

Trainieren von Algorithmen zur Ergebnisoptimierung

Auch was das Matching des Cultural Fit angeht, scheint mir die IBM-Lösung aus meiner Sicht nicht ganz so leicht verständlich: Angeblich werde auf Basis der bestehenden Unternehmenskultur ein Cultural Profil erstellt. Wie diese Unternehmenskultur durch Watson jedoch erhoben und der Datenanalyse zugänglich gemacht wird, bleibt für mich im Dunkeln. So oder so müssen aber notwendige Anpassungen mit dem Fokus der zukünftigen Wunschkultur wieder im Rahmen eines individuellen Algorithmen-Trainings erfolgen.

Ich habe also gelernt, dass fast immer ein Trainieren der Algorithmen notwendig ist. Auch wenn ich mir nicht sicher bin, ob es dieses Begriffspaar gibt, so muss ich jetzt an eine „versubjektivierte Objektivität“ denken. Einerseits werden Algorithmen gerne mit dem Argument der höheren Objektivität verkauft. Aber wenn andererseits am Ende dann doch ein subjektiver (willkürlicher) Eingriff ins Ergebnis stattfinden muss… Mir kommen Zweifel. Berechtigterweise, wie ein stark diskutierter Fall in Österreich beweist.

Wer die Supercomputer beherrscht, hat die Macht

Auch wenn ich es schon immer gewusst habe, so trifft mich trotzdem erneut die Erkenntnis, dass alle Diskussionen zum Thema Objektivität von Analyseergebnissen daran kranken, dass der zugrundeliegende Algorithmus entweder „nachtrainiert“ werden muss bzw. selbst das Ergebnis eines menschlichen Schaffensprozesses ist. Auch wenn Google kürzlich verkündet hat, dass deren KI mittlerweile bessere KI programmiert als deren menschliche Softwareentwickler, so steht am Anfang dennoch immer noch ein menschlicher Ursprung. Die Bedenken dass KI dem Machtmissbrauch und der Manipulation Tür und Tor öffnen und die Technik lediglich die Vorurteile der Programmierer abbilden, haben laut einer letzte Woche veröffentlichten BITKOM-Studie, fast drei Viertel aller für die Studie befragten Teilnehmer.

So wie Google uns durch seinen geheimen Suchalgorithmus maßgeblich in unserem täglichen Leben massiv beeinflusst oder Facebook uns durch seinen Algorithmus mit News beglückt, werden wir Nicht-Wissenschaftler auf lange Sicht damit leben müssen, dass wir nicht wissen, warum Software uns in die eine oder andere Richtung zu schieben versucht.

Was wir aber tun können: Skeptisch bleiben und versuchen möglichst viel nachzuvollziehen. Bis hin zur Komplettverweigerung dort, wo wir nicht mitgehen können. Zumindest ist das beim heutigen Stand der Wissenschaft noch in vielen Punkten gut möglich.

Kein Richtig und kein Falsch, nur Interpretation

Apropos Wissenschaft: Ich habe in meinem Leben mehrere Erkenntnisphasen durchlaufen. Oder nennen wir es gar Erkenntnissprünge. Nach der schulischen Ausbildung glaubte ich noch an ein berechenbares Richtig oder Falsch. Biologie, Chemie, Mathematik – Naturwissenschaft war nachvollziehbar. Selbst Religion in sich stimmig. Mit dem Jurastudium kam dann der Schock: „Es kommt darauf an!“, ein juristischer Standardsatz, läutete die Wende ein. Plötzlich gab es nicht mehr „die eine richtige Lösung“, sondern mehrere diskutierbare.

Studien dienen vor allem dem Sponsor derselben

Die zweite Erkenntnis kam etwas später und ist heute umso tragischer: Wissenschaftliche Studien sind ebenfalls in (zu) vielen Fällen mittlerweile zu einem Mittel zum Zweck verkommen. Der Auftraggeber oder Sponsor gibt Studien in Auftrag, um vordefinierte oder zumindest vom Tenor her vorbestimmte Ergebnisse für sich verwenden zu können.

Es kann doch kein Zufall sein, dass bei Studien immer für den Sponsor vermarktbare Ergebnisse herauskommen. Verkauft ein Dienstleister Produkt A, dann beweist seine Studie selbstverständlich, dass mit dem Produkt A das Leben viel besser und einfacher ist. Gleiches gilt für den Anbieter des gegensätzlichen Produkts B. In meiner Präsentation auf der HR-Messe Zukunft Personal im Rahmen der Blogger-Lounge 2017 habe ich einige Beispiele dazu gebracht.

OK, so ist das Spiel. Damit kann ich leben. Weil ich glaube es verstanden zu haben.

Die Supercomputer – Rettung für das Personalmanagement?

Aber zurück zum Thema: Warum nochmal sollten Supercomputer Gutes für HR tun? Im Grund geht es ebenfalls nur um ein Geschäftsmodell. Und das muss sich rechnen. Selbst heute bereits heilbare Krankheiten lässt die Forschung der Pharmakonzerne dann außen vor, wenn sich mit dem Forschungsergebnis kein Geld verdienen lässt. Ethisch sinnvolle Medikamente werden nicht entwickelt, wenn sich damit kein Profit erzielen lässt. Ich denke, wir müssen den Tatsachen hier direkt ins Auge sehen.

Insofern gilt wie so oft: Wer sich die Unterstützung von Algorithmen für seine Prozesse einkaufen will, benötigt einerseits die notwendigen finanziellen Ressourcen und muss sich andererseits dennoch bewusst sein, dass ein hohes Maß an eigenem Input notwendig ist, um brauchbare Ergebnisse zu erzielen.

Ergebnisse sind abhängig von der Datenqualität

Supercomputer arbeiten auf Basis von Daten, die ihnen zur Verfügung gestellt werden. Im Rahmen von Big Data Analysen entstehen dann neue Erkenntnisse. Vorausgesetzt, die Qualität der verfügbaren Daten ist entsprechend hoch. Amerikanische Unternehmen, die einen etwas lockereren Umgang mit dem Thema Datenschutz pflegen als Unternehmen in Deutschland, erheben deutlich mehr solche Daten innerhalb des Unternehmens, insbesondere von Mitarbeitern. Die Datenqualität übersteigt die der typischen deutschen Personalabteilung um ein Vielfaches. Insofern sind Erfolge von Supercomputern in den USA nicht 1:1 auf den HR-Markt in Deutschland übertragbar.

#Unternehmen in #Deutschland tracken #Mitarbeiterskills und #Kompetenzen noch zu wenig für #BigData-#Analysen. Share on XDie umfangreichen Implikationen im Bereich Datenschutz, mag ich an dieser Stelle nicht weiter vertiefen. Meine Meinung dazu habe ich bereits im Beitrag Datenschutz ist tot ausführlich dargestellt.

Fazit

Die Rechnerleistung von Supercomputern wie Watson ist faszinierend und Big Data ein höchst spannendes Feld. People Analytics ist auf dem Vormarsch auch in deutschen Personalabteilungen. Allerdings dürfen die aktuellen Möglichkeiten und Ergebnisse nicht überschätzt werden. Es sind häufig noch sehr viele manuelle Eingriffe und Trainingsläufe notwendig, um aus unstrukturierten Einzeldaten wertvolle Erkenntnisse zu erlangen.

So lange die Datenbasis, auf der Analyseergebnisse beruhen, nicht signifikant verbessert wird, halten sich die Erkenntnisgewinne in einem überschaubaren Rahmen. Was nicht heißt, dass es nicht bereits heute eine gute Basis gibt, um das Thema Algorithmen-basiertes Recruiting noch stärker zum Erfolg zu führen. Trotzdem würde ich die im Titel aufgeworfene Frage derzeit mit einem klaren „Nein!“ beantworten.

Auch wenn mein Beitrag möglicherweise stark mit kritischen Gedanken durchzogen ist und ab und an etwas ins Philosophische abgleitet. Mir ist es wichtig, in der medialen Diskussion gerade diese Aspekte ebenfalls zu beleuchten. Selbstverständlich bleibe ich weiter an diesen Themen dran – HR steht hier erst ganz am Anfang.

Vielen Dank an IBM und insbesondere Sven Semet für den ausführlichen Gesprächstermin!

Mein Name ist Stefan Scheller. In meiner Rolle als Persoblogger und Top HR-Influencer betreibe ich diese Website und das gleichnamige

Mein Name ist Stefan Scheller. In meiner Rolle als Persoblogger und Top HR-Influencer betreibe ich diese Website und das gleichnamige

Newsletter

Newsletter